Rapport n° 464 (2016-2017) de M. Claude DE GANAY, député et Mme Dominique GILLOT , sénatrice, fait au nom de l'Office parlementaire d'évaluation des choix scientifiques et technologiques, déposé le 15 mars 2017

Disponible au format PDF (2,9 Moctets)

-

ANNEXE 1 : LISTE DES DÉPLACEMENTS DES

RAPPORTEURS

-

ANNEXE 2 : PANORAMAS DE L'INTELLIGENCE

ARTIFICIELLE

-

ANNEXE 3 : SUR LE DROIT COMPARÉ DE LA

ROBOTIQUE

-

ANNEXE 4 : CONTRIBUTION DE M. RAJA

CHATILA,

DIRECTEUR DE L'INSTITUT DES SYSTÈMES INTELLIGENTS ET DE ROBOTIQUE (ISIR)

« ROBOTIQUE ET INTELLIGENCE ARTIFICIELLE »

-

ANNEXE 5 : CONTRIBUTION DE M. PATRICK ALBERT,

ENTREPRENEUR ET CHERCHEUR :

RELEVER DÉMOCRATIQUEMENT

LES DÉFIS DE L'INTELLIGENCE ARTIFICIELLE

-

ANNEXE 6 : RÉPONSES ÉCRITES AUX

RAPPORTEURS

-

I. RÉPONSES D'AXELLE LEMAIRE,

SECRÉTAIRE D'ÉTAT CHARGÉE DU NUMÉRIQUE ET DE

L'INNOVATION, ET DE THIERRY MANDON, SECRÉTAIRE D'ÉTAT

CHARGÉ DE L'ENSEIGNEMENT SUPÉRIEUR ET DE LA RECHERCHE, AU

QUESTIONNAIRE DE VOS RAPPORTEURS

-

II. RÉPONSES À LA CONSULTATION

ORGANISÉE PAR LE PARIS MACHINE LEARNING MEETUP EN VUE DU RAPPORT DE

L'OPECST

-

I. RÉPONSES D'AXELLE LEMAIRE,

SECRÉTAIRE D'ÉTAT CHARGÉE DU NUMÉRIQUE ET DE

L'INNOVATION, ET DE THIERRY MANDON, SECRÉTAIRE D'ÉTAT

CHARGÉ DE L'ENSEIGNEMENT SUPÉRIEUR ET DE LA RECHERCHE, AU

QUESTIONNAIRE DE VOS RAPPORTEURS

-

ANNEXE 7 : COMPTE RENDU DE L'AUDITION

PUBLIQUE DU 19 JANVIER 2017

-

I. INTRODUCTION

-

II. PREMIÈRE TABLE RONDE,

PRÉSIDÉE PAR M. CLAUDE DE GANAY, RAPPORTEUR : LES

TECHNOLOGIES RELEVANT DE L'INTELLIGENCE ARTIFICIELLE

-

1. Mme Dominique Gillot, sénatrice, membre

de l'OPECST, rapporteure

-

2. M. Claude de Ganay, député, membre

de l'OPECST, rapporteur

-

3. M. Jean-Gabriel Ganascia, professeur à

l'Université Pierre-et-Marie-Curie, Paris-VI

-

4. M. Gérard Sabah, directeur de recherche

honoraire au CNRS

-

5. M. Yves Demazeau, président de

l'Association française pour l'intelligence artificielle

-

6. M. Bertrand Braunschweig, directeur du centre

Inria de Saclay

-

7. M. David Sadek, directeur de la recherche

à l'Institut Mines-Télécom

-

8. M. Jean-Daniel Kant, maître de

conférences à l'Université Pierre-et-Marie-Curie

Paris-VI

-

9. M. Benoît Le Blanc, directeur adjoint

de l'École nationale supérieure de cognitique

-

10. Débat

-

1. Mme Dominique Gillot, sénatrice, membre

de l'OPECST, rapporteure

-

III. DEUXIÈME TABLE RONDE,

PRÉSIDÉE PAR MME DOMINIQUE GILLOT, RAPPORTEURE : DIMENSIONS

STRATÉGIQUES EN MATIÈRE DE RECHERCHE EN INTELLIGENCE

ARTIFICIELLE

-

1. M. Jean-Marc Merriaux, directeur

général de Canopé

-

2. M. François Taddei, directeur du Centre

de recherche interdisciplinaire (CRI)

-

3. M. Olivier Esper, responsable des affaires

publiques de Google France

-

4. Mme Delphine Reyre, directrice Europe des

affaires publiques de Facebook

-

5. M. Laurent Massoulié, directeur du

Centre de recherche commun Inria-Microsoft

-

6. M. Dominique Cardon, professeur de

sociologie à l'Institut d'Études Politiques de

Paris/Médialab

-

7. M. Gilles Babinet, entrepreneur, digital

champion auprès de la Commission européenne

-

8. Débat

-

1. M. Jean-Marc Merriaux, directeur

général de Canopé

-

IV. TROISIÈME TABLE RONDE,

PRÉSIDÉE PAR MME DOMINIQUE GILLOT, RAPPORTEURE :

QUESTIONS POLITIQUES, SOCIÉTALES ET ÉCONOMIQUES LIÉES

À L'IRRUPTION DES TECHNOLOGIES DE L'INTELLIGENCE ARTIFICIELLE

-

1. M. Henri Verdier, directeur

interministériel du numérique

-

2. Mme Marie-Claire

Carrère-Gée, présidente du Conseil d'orientation pour

l'emploi (COE)

-

3. M. Laurent Alexandre, entrepreneur (DNA vision)

-

4. M. Jean-Christophe Baillie, entrepreneur

(Novaquark)

-

5. M. Jean-Claude Heudin, directeur de

l'Institut de l'Internet et du multimédia

-

6. Débat

-

1. M. Henri Verdier, directeur

interministériel du numérique

-

V. INTERVENTION DE LA MINISTRE : AXELLE

LEMAIRE, SECRÉTAIRE D'ÉTAT CHARGÉE DU NUMÉRIQUE ET

DE L'INNOVATION

-

VI. QUATRIÈME TABLE RONDE,

PRÉSIDÉE PAR M. CLAUDE DE GANAY, RAPPORTEUR : ENJEUX

ÉTHIQUES DE L'INTELLIGENCE ARTIFICIELLE

-

1. M. Gilles Dowek, directeur de recherche Inria,

professeur attaché à l'ENS Paris-Saclay

-

2. Mme Laurence Devillers, professeur à

l'Université Paris-Sorbonne/LMSI-CNRS

-

3. M. Serge Abiteboul, directeur de recherche

Inria

-

4. M. Jean Ponce, professeur et directeur du

département d'informatique de l'École normale supérieure

(ENS)

-

5. M. Serge Tisseron, psychiatre, chercheur

associé à l'Université Paris Diderot-Paris VII

-

1. M. Gilles Dowek, directeur de recherche Inria,

professeur attaché à l'ENS Paris-Saclay

-

VII. CINQUIÈME TABLE RONDE,

PRÉSIDÉE PAR MME DOMNIQUE GILLOT, RAPPORTEURE :

DÉFIS JURIDIQUES INHÉRENTS AUX USAGES DE L'INTELLIGENCE

ARTIFICIELLE

-

1. Intervention de Mady Delvaux,

députée européenne (Luxembourg - groupe

S&D), rapporteure du groupe de travail sur la robotique et l'intelligence

artificielle

-

2. Mme Isabelle Falque-Pierrotin,

présidente de la CNIL

-

3. M. Rand Hindi, membre du Conseil national du

numérique, pilote du groupe de travail sur l'intelligence artificielle,

président de SNIPS

-

4. M. Olivier Guilhem, directeur juridique chez

SoftBank Robotics (ex Aldebaran)

-

5. Me Alain Bensoussan, avocat, président

de l'Association du droit des robots

-

6. Débat

-

1. Intervention de Mady Delvaux,

députée européenne (Luxembourg - groupe

S&D), rapporteure du groupe de travail sur la robotique et l'intelligence

artificielle

-

VIII. CONCLUSION

-

I. INTRODUCTION

-

ANNEXE 8 : COMPTES RENDUS DES AUDITIONS

BILATÉRALES CONDUITES PAR LES RAPPORTEURS

-

I. AUDITIONS DU 25 OCTOBRE 2016

-

II. AUDITIONS DU 8 NOVEMBRE 2016

-

III. AUDITIONS DU 9 NOVEMBRE 2016

-

1. Me Alain Bensoussan, avocat, président

de l'association pour les droits des robots et Me Marie Soulez, avocate

spécialisée sur les TIC dans son cabinet

-

2. M. Henri Verdier, directeur

interministériel du numérique, ancien entrepreneur et

spécialiste du numérique

-

3. M. Laurent Alexandre, président de DNA

Vision, fondateur de Doctissimo, chirurgien-urologue

-

4. M. Pierre-Yves Oudeyer, directeur de recherche

Inria, directeur du laboratoire Flowers, président du comité

technique des systèmes cognitifs et développementaux de l'IEEE

(Institut des ingénieurs électriciens et

électroniciens)

-

1. Me Alain Bensoussan, avocat, président

de l'association pour les droits des robots et Me Marie Soulez, avocate

spécialisée sur les TIC dans son cabinet

-

IV. AUDITIONS DU 24 NOVEMBRE 2016

-

1. Mme Flora Fischer, chargée de programme

de recherche au CIGREF, Club informatique des grandes entreprises

françaises, pilote du groupe de travail sur l'intelligence artificielle

en entreprise

-

2. M. Max Dauchet, professeur

émérite à l'Université de Lille, président

de la Commission de Réflexion sur l'Éthique de la Recherche en

sciences et technologies du numérique (CERNA) d'Allistene, alliance des

sciences et technologies du numérique

-

3. M. Cédric Sauviat, ingénieur,

président de l'association française contre l'intelligence

artificielle (AFCIA) et Mme Marie David, ingénieur, éditrice,

membre du bureau de l'association

-

1. Mme Flora Fischer, chargée de programme

de recherche au CIGREF, Club informatique des grandes entreprises

françaises, pilote du groupe de travail sur l'intelligence artificielle

en entreprise

-

V. AUDITIONS DU 28 NOVEMBRE 2016

-

1. M. Claude Berrou, professeur à

Télécom Bretagne (Institut Mines-Télécom),

chercheur en électronique et informatique, membre de l'Académie

des sciences

-

2. M. Nicolas Cointe et Mme Fiona Berreby,

chercheurs en thèse de doctorat sur l'éthique de l'intelligence

artificielle

-

3. Mme Laurence Devillers, professeur

d'informatique à l'Université Paris-Sorbonne et directrice de

recherche du CNRS au Laboratoire d'informatique pour la mécanique et les

sciences de l'ingénieur (Limsi de Saclay)

-

1. M. Claude Berrou, professeur à

Télécom Bretagne (Institut Mines-Télécom),

chercheur en électronique et informatique, membre de l'Académie

des sciences

-

VI. AUDITIONS DU 30 NOVEMBRE 2016

-

1. M. David Sadek, directeur de la recherche de

l'Institut Mines-Télécom, spécialiste en intelligence

artificielle

-

2. M. Dominique Sciamma, directeur de

l'école de design « Strate » à

Sèvres

-

3. M. François Taddéi, directeur du

Centre de recherches interdisciplinaires (Inserm, Université

Paris-Descartes), biologiste

-

4. M. Igor Carron, entrepreneur, organisateur du

principal « meet-up » en intelligence artificielle en

France intitulé « Paris Machine Learning »

-

5. M. Jill-Jênn Vie, chercheur en

thèse de doctorat à l'École normale supérieure

Paris-Saclay

-

1. M. David Sadek, directeur de la recherche de

l'Institut Mines-Télécom, spécialiste en intelligence

artificielle

-

I. AUDITIONS DU 25 OCTOBRE 2016

|

N° 4594 |

N° 464 |

|

|

ASSEMBLÉE NATIONALE |

SÉNAT |

|

|

CONSTITUTION DU 4 OCTOBRE 1958 QUATORZIÈME LÉGISLATURE |

SESSION ORDINAIRE 2016 - 2017 |

|

|

Enregistré à la présidence de l'Assemblée nationale |

Enregistré à la présidence du Sénat |

|

|

le 15 mars 2017 |

le 15 mars 2017 |

RAPPORT

au nom de

L'OFFICE PARLEMENTAIRE D'ÉVALUATION

DES CHOIX SCIENTIFIQUES ET

TECHNOLOGIQUES

POUR UNE INTELLIGENCE ARTIFICIELLE

MAÎTRISÉE, UTILE ET DÉMYSTIFIÉE

PAR

M. Claude de GANAY, député, et Mme Dominique

GILLOT, sénatrice

Tome II : Annexes

|

Déposé sur le Bureau de l'Assemblée nationale par M. Jean-Yves LE DÉAUT, Président de l'Office |

Déposé sur le Bureau du Sénat par M. Bruno SIDO, Premier vice-président de l'Office |

Composition de l'Office parlementaire

d'évaluation des choix scientifiques

et technologiques

Président

M. Jean-Yves LE DÉAUT, député

Premier vice-président

M. Bruno SIDO, sénateur

Vice-présidents

M. Christian BATAILLE, député M. Roland COURTEAU, sénateur

Mme Anne-Yvonne LE DAIN, députée M. Christian NAMY, sénateur

M. Jean-Sébastien VIALATTE, député Mme Catherine PROCACCIA, sénateur

|

DÉPUTÉS |

SÉNATEURS |

|

M. Bernard ACCOYER M. Gérard BAPT M. Alain CLAEYS M. Claude de GANAY Mme Françoise GUÉGOT M. Patrick HETZEL M. Laurent KALINOWSKI M. Alain MARTY M. Philippe NAUCHE Mme Maud OLIVIER Mme Dominique ORLIAC M. Bertrand PANCHER M. Jean-Louis TOURAINE |

M. Patrick ABATE M. Gilbert BARBIER Mme Delphine BATAILLE M. Michel BERSON M. François COMMEINHES Mme Catherine GÉNISSON Mme Dominique GILLOT M. Alain HOUPERT Mme Fabienne KELLER M. Jean-Pierre LELEUX M. Gérard LONGUET M. Pierre MÉDEVIELLE M. Franck MONTAUGÉ M. Hervé POHER |

SOMMAIRE

Pages

ANNEXE 1 : LISTE DES DÉPLACEMENTS DES RAPPORTEURS 7

ANNEXE 2 : PANORAMAS DE L'INTELLIGENCE ARTIFICIELLE 9

1. Aux États-Unis 9

2. En Chine 21

3. Au Japon 27

4. Au Royaume-Uni 36

5. En Suisse 43

ANNEXE 3 : SUR LE DROIT COMPARÉ DE LA ROBOTIQUE 49

ANNEXE 4 : CONTRIBUTION DE M. RAJA CHATILA, DIRECTEUR DE L'INSTITUT DES SYSTÈMES INTELLIGENTS ET DE ROBOTIQUE (ISIR) « ROBOTIQUE ET INTELLIGENCE ARTIFICIELLE » 75

ANNEXE 5 : CONTRIBUTION DE M. PATRICK ALBERT, ENTREPRENEUR ET CHERCHEUR : RELEVER DÉMOCRATIQUEMENT LES DÉFIS DE L'INTELLIGENCE ARTIFICIELLE 79

ANNEXE 6 : RÉPONSES ÉCRITES AUX RAPPORTEURS 95

I. RÉPONSES D'AXELLE LEMAIRE, SECRÉTAIRE D'ÉTAT CHARGÉE DU NUMÉRIQUE ET DE L'INNOVATION, ET DE THIERRY MANDON, SECRÉTAIRE D'ÉTAT CHARGÉ DE L'ENSEIGNEMENT SUPÉRIEUR ET DE LA RECHERCHE, AU QUESTIONNAIRE DE VOS RAPPORTEURS 95

II. RÉPONSES À LA CONSULTATION ORGANISÉE PAR LE PARIS MACHINE LEARNING MEETUP EN VUE DU RAPPORT DE L'OPECST 108

ANNEXE 7 : COMPTE RENDU DE L'AUDITION PUBLIQUE DU 19 JANVIER 2017 115

I. INTRODUCTION 115

1. M. Bruno Sido, sénateur, premier vice-président de l'OPECST 115

2. M. Jean-Yves Le Déaut, député, président de l'OPECST 116

II. PREMIÈRE TABLE RONDE, PRÉSIDÉE PAR M. CLAUDE DE GANAY, RAPPORTEUR : LES TECHNOLOGIES RELEVANT DE L'INTELLIGENCE ARTIFICIELLE 119

1. Mme Dominique Gillot, sénatrice, membre de l'OPECST, rapporteure 119

2. M. Claude de Ganay, député, membre de l'OPECST, rapporteur 119

3. M. Jean-Gabriel Ganascia, professeur à l'Université Pierre-et-Marie-Curie, Paris-VI 120

4. M. Gérard Sabah, directeur de recherche honoraire au CNRS 123

5. M. Yves Demazeau, président de l'Association française pour l'intelligence artificielle 127

6. M. Bertrand Braunschweig, directeur du centre Inria de Saclay 134

7. M. David Sadek, directeur de la recherche à l'Institut Mines-Télécom 138

8. M. Jean-Daniel Kant, maître de conférences à l'Université Pierre-et-Marie-Curie Paris_VI 140

9. M. Benoît Le Blanc, directeur adjoint de l'École nationale supérieure de cognitique 142

10. Débat 145

III. DEUXIÈME TABLE RONDE, PRÉSIDÉE PAR MME DOMINIQUE GILLOT, RAPPORTEURE : DIMENSIONS STRATÉGIQUES EN MATIÈRE DE RECHERCHE EN INTELLIGENCE ARTIFICIELLE 150

1. M. Jean-Marc Merriaux, directeur général de Canopé 150

2. M. François Taddei, directeur du Centre de recherche interdisciplinaire (CRI) 152

3. M. Olivier Esper, responsable des affaires publiques de Google France 154

4. Mme Delphine Reyre, directrice Europe des affaires publiques de Facebook 156

5. M. Laurent Massoulié, directeur du Centre de recherche commun Inria-Microsoft 158

6. M. Dominique Cardon, professeur de sociologie à l'Institut d'Études Politiques de Paris/Médialab 159

7. M. Gilles Babinet, entrepreneur, digital champion auprès de la Commission européenne 161

8. Débat 163

IV. TROISIÈME TABLE RONDE, PRÉSIDÉE PAR MME DOMINIQUE GILLOT, RAPPORTEURE : QUESTIONS POLITIQUES, SOCIÉTALES ET ÉCONOMIQUES LIÉES À L'IRRUPTION DES TECHNOLOGIES DE L'INTELLIGENCE ARTIFICIELLE 172

1. M. Henri Verdier, directeur interministériel du numérique 172

2. Mme Marie-Claire Carrère-Gée, présidente du Conseil d'orientation pour l'emploi (COE) 174

3. M. Laurent Alexandre, entrepreneur (DNA vision) 177

4. M. Jean-Christophe Baillie, entrepreneur (Novaquark) 182

5. M. Jean-Claude Heudin, directeur de l'Institut de l'Internet et du multimédia 185

6. Débat 187

V. INTERVENTION DE LA MINISTRE : AXELLE LEMAIRE, SECRÉTAIRE D'ÉTAT CHARGÉE DU NUMÉRIQUE ET DE L'INNOVATION 192

Débat 195

VI. QUATRIÈME TABLE RONDE, PRÉSIDÉE PAR M. CLAUDE DE GANAY, RAPPORTEUR : ENJEUX ÉTHIQUES DE L'INTELLIGENCE ARTIFICIELLE 198

1. M. Gilles Dowek, directeur de recherche Inria, professeur attaché à l'ENS Paris-Saclay 198

2. Mme Laurence Devillers, professeur à l'Université Paris-Sorbonne/LMSI-CNRS 201

3. M. Serge Abiteboul, directeur de recherche Inria 203

4. M. Jean Ponce, professeur et directeur du département d'informatique de l'École normale supérieure (ENS) 205

5. M. Serge Tisseron, psychiatre, chercheur associé à l'Université Paris Diderot-Paris VII 206

VII. CINQUIÈME TABLE RONDE, PRÉSIDÉE PAR MME DOMNIQUE GILLOT, RAPPORTEURE : DÉFIS JURIDIQUES INHÉRENTS AUX USAGES DE L'INTELLIGENCE ARTIFICIELLE 209

1. Intervention de Mady Delvaux, députée européenne (Luxembourg - groupe S&D), rapporteure du groupe de travail sur la robotique et l'intelligence artificielle 209

2. Mme Isabelle Falque-Pierrotin, présidente de la CNIL 212

3. M. Rand Hindi, membre du Conseil national du numérique, pilote du groupe de travail sur l'intelligence artificielle, président de SNIPS 213

4. M. Olivier Guilhem, directeur juridique chez SoftBank Robotics (ex Aldebaran) 214

5. M e Alain Bensoussan, avocat, président de l'Association du droit des robots 216

6. Débat 217

VIII. CONCLUSION 218

ANNEXE 8 : COMPTES RENDUS DES AUDITIONS BILATÉRALES CONDUITES PAR LES RAPPORTEURS 219

I. AUDITIONS DU 25 OCTOBRE 2016 219

1. M. Stéphane Mallat, professeur à l'École normale supérieure (ENS), chercheur en mathématiques appliquées 219

2. M. Patrick Albert, entrepreneur (créateur de ILOG), chercheur et pionnier dans le domaine de l'intelligence artificielle 221

II. AUDITIONS DU 8 NOVEMBRE 2016 222

1. M. Marc Mézard, directeur de l'École normale supérieure (ENS) 222

2. M. Raja Chatila, directeur de recherche au Centre national de la recherche scientifique (CNRS), directeur de l'Institut des systèmes intelligents et de robotique (ISIR) 224

III. AUDITIONS DU 9 NOVEMBRE 2016 226

1. M e Alain Bensoussan, avocat, président de l'association pour les droits des robots et M e Marie Soulez, avocate spécialisée sur les TIC dans son cabinet 226

2. M. Henri Verdier, directeur interministériel du numérique, ancien entrepreneur et spécialiste du numérique 229

3. M. Laurent Alexandre, président de DNA Vision, fondateur de Doctissimo, chirurgien-urologue 230

4. M. Pierre-Yves Oudeyer, directeur de recherche Inria, directeur du laboratoire Flowers, président du comité technique des systèmes cognitifs et développementaux de l'IEEE (Institut des ingénieurs électriciens et électroniciens) 232

IV. AUDITIONS DU 24 NOVEMBRE 2016 240

1. Mme Flora Fischer, chargée de programme de recherche au CIGREF, Club informatique des grandes entreprises françaises, pilote du groupe de travail sur l'intelligence artificielle en entreprise 240

2. M. Max Dauchet, professeur émérite à l'Université de Lille, président de la Commission de Réflexion sur l'Éthique de la Recherche en sciences et technologies du numérique (CERNA) d'Allistene, alliance des sciences et technologies du numérique 243

3. M. Cédric Sauviat, ingénieur, président de l'association française contre l'intelligence artificielle (AFCIA) et Mme Marie David, ingénieur, éditrice, membre du bureau de l'association 246

V. AUDITIONS DU 28 NOVEMBRE 2016 257

1. M. Claude Berrou, professeur à Télécom Bretagne (Institut Mines-Télécom), chercheur en électronique et informatique, membre de l'Académie des sciences 257

2. M. Nicolas Cointe et Mme Fiona Berreby, chercheurs en thèse de doctorat sur l'éthique de l'intelligence artificielle 259

3. Mme Laurence Devillers, professeur d'informatique à l'Université Paris-Sorbonne et directrice de recherche du CNRS au Laboratoire d'informatique pour la mécanique et les sciences de l'ingénieur (Limsi de Saclay) 262

VI. AUDITIONS DU 30 NOVEMBRE 2016 264

1. M. David Sadek, directeur de la recherche de l'Institut Mines-Télécom, spécialiste en intelligence artificielle 264

2. M. Dominique Sciamma, directeur de l'école de design « Strate » à Sèvres 266

3. M. François Taddéi, directeur du Centre de recherches interdisciplinaires (Inserm, Université Paris-Descartes), biologiste 269

4. M. Igor Carron, entrepreneur, organisateur du principal « meet-up » en intelligence artificielle en France intitulé « Paris Machine Learning » 270

5. M. Jill-Jênn Vie, chercheur en thèse de doctorat à l'École normale supérieure Paris-Saclay 271

ANNEXE 1 : LISTE DES DÉPLACEMENTS DES RAPPORTEURS

Vos rapporteurs ont effectué les déplacements suivants :

- un déplacement aux États-Unis d'Amérique du 22 au 29 janvier 2017, pour rencontrer des spécialistes de l'intelligence artificielle, à Washington à l'Institut de technologie du Massachusetts (MIT), à la Harvard Kennedy School of Government , à l'Université de Washington, à l'Université de Stanford, à l'Université de Berkeley, ainsi que des représentants de Facebook (Menlo Park, Palo Alto), de Google (Mountain View), d'Apple (Cupertino) et de Salesforce (San Francisco)... ;

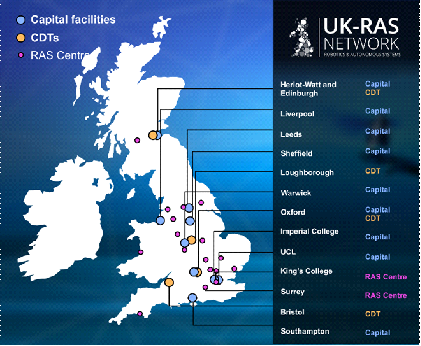

- trois déplacements en Europe : à Genève du 21 au 22 septembre 2016 (HBP et BBP du Brain Mind Institute de l'École polytechnique fédérale de Lausanne, EPFL), au Royaume-Uni du 13 au 16 décembre 2016 (Chambre des Communes, Royal Society, Alan Turing Institute , Future of humanity Institute de l'Université d'Oxford, CSER et LCFI de Cambridge...) et à Bruxelles du 8 au 9 février 2017 (laboratoire d'intelligence artificielle de l'Université libre de Bruxelles, institutions européennes...) ;

- un déplacement en France métropolitaine, à Arcachon du 26 au 30 septembre 2016, pour participer à un séminaire sur l'éthique de l'intelligence artificielle organisé par la commission de réflexion sur l'éthique de la recherche en sciences et technologies du numérique d'Allistene (CERNA).

ANNEXE 2 : PANORAMAS DE L'INTELLIGENCE ARTIFICIELLE

1. Aux États-Unis

Note réalisée avec le concours du service scientifique de l'Ambassade de France aux États-Unis et en particulier du Consulat de San Francisco

S'il fallait un indice de la prise de conscience collective aux États-Unis de l'importance critique du développement de l'intelligence artificielle dans ses perspectives scientifiques et technologiques mais également et peut-être surtout économiques et sociétales, le fait que le Président Barack Obama ait choisi de consacrer la dernière de ses grandes apparitions publiques consacrées à la science et à la technologie à un entretien extrêmement médiatisé avec Joi Ito, le directeur du prestigieux MIT Media Lab, publié dans le plus grand magazine de vulgarisation technologique du monde, et entièrement dédié à une discussion autour de l'intelligence artificielle 1 ( * ) constitue probablement un assez bon indicateur de ce que cette thématique technologique est le sujet brûlant du moment aux États-Unis, que ce soit dans l'expression de politiques publiques, la consolidation d'une puissance de recherche inégalée ou le développement rapide et sans précédent d'activités économiques liées.

1. Les politiques publiques liées au développement de l'intelligence artificielle

Consciente de la tension entre l'impact potentiellement bénéfique des progrès technologiques dans le champ de l'intelligence artificielle et de leur percolation dans un nombre croissant de champs d'activité économique d'une part, et de ses potentielles implications structurantes sur la société, relayées publiquement de surcroît par diverses personnalités en vue du monde scientifique et industriel, d'autre part, la Maison Blanche a mis en place en mai 2016 un sous-comité spécifique au sein du National Science and Technology Council (NSTC), chargé de suivre les évolutions du secteur et de coordonner les activités fédérales sur le sujet. En parallèle ont été tenues quatre sessions de travail publiques entre les mois de mai et juillet 2016, visant à engager la discussion avec le grand public et surtout à produire une large évaluation des opportunités, risques, et implications réglementaires et sociales de l'intelligence artificielle, de même qu'une série de recommandations dotées d'un plan stratégique afin de se donner les moyens de les mettre en oeuvre. Les conclusions de ces travaux ont donné lieu à pas moins de trois rapports produits par l'administration Obama entre octobre et décembre 2016.

1.1 Preparing the Future of Artificial Intelligence (NSTC, octobre 2016)

Ce premier rapport, assez peu détaillé, a pour objectif de produire un cadre général à la réflexion nationale, en amorçant un état des lieux de la recherche et des applications actuelles tout en posant des jalons initiaux quant à la possibilité et la nature d'une régulation.

En particulier, le rapport conclut, avec un optimisme affiché, que l'intelligence artificielle et l'apprentissage automatique font émerger le potentiel d'améliorer la vie des citoyens en permettant de résoudre certains des plus grands enjeux sociétaux. La santé, les transports, l'environnement, la justice ou encore l'efficacité du gouvernement lui-même sont autant de secteurs applicatifs mis en avant.

Cela étant, les auteurs insistent sur l'importance de la réglementation dans l'accompagnement de ces avancées technologiques. Si un consensus se dégage pour conclure qu'une réglementation générale de la recherche en IA semble inapplicable à l'heure actuelle, et, partant, la réglementation actuelle est pour l'heure suffisante, l'approche explicite guidant les prochains arbitrages se devra de procéder selon le principe suivant : évaluer les risques que l'implémentation de l'IA pourrait réduire, de même que ceux qu'elle pourrait augmenter. L'analyse comparée des risques et des bénéfices permettra de justifier les futures décisions d'ordre réglementaire. En outre, le rapport insiste sur l'importance d'ajuster les réglementations afin de réduire, au maximum, les coûts et les barrières à l'innovation sans mettre en danger la sécurité du public ou la compétition équitable sur le marché.

Ce n'est pas pour autant diminuer le rôle pivot des autorités fédérales. De ce point de vue, le Gouvernement a plusieurs rôles à jouer : un rôle d'organisateur du débat public et d'arbitre des mesures à mettre en place à l'échelle du pays ; un rôle de suivi attentif de la sécurité et de la neutralité des applications développées ; un rôle de producteur de réglementations encourageant l'innovation tout en protégeant le public ; un rôle d'accompagnateur de la diffusion de ces technologies tout en protégeant certains secteurs au besoin afin d'éviter des contrecoups économiques dévastateurs ; un rôle de soutien et de financeur de projets de recherche faisant avancer le domaine ; et enfin un rôle d'adoption en son sein même de ces avancées afin d'assurer un service public de meilleure qualité.

En particulier, dans cette position, le gouvernement fédéral a un rôle clé à jouer dans l'avancement de l'IA en termes de R&D, en particulier à travers la production d'une main-d'oeuvre en nombre suffisant, ainsi que d'un haut niveau de qualification et de diversité technique, non seulement d'un point de vue professionnel, mais également, et de manière plus large, du point de vue de la formation générale de la population.

En termes d'impact économique, le rapport conclut que le premier effet à court terme sera celui de l'automatisation d'un nombre grandissant de tâches. Si la productivité générale et la création de richesse ont toutes les chances d'être positivement impactées, l'impact sur l'emploi est lui plus difficile à évaluer. Ce dernier sera inégal en fonction des professions, et le sous-comité suggère que les professions à faible salaire seront les plus touchées, et que l'automatisation aggrave le fossé entre travailleurs hautement formés et travailleurs faiblement éduqués, s'accompagnant potentiellement d'une augmentation des inégalités économiques. Dans cette optique, le rôle du gouvernement serait ici d'assurer le maintien de certaines catégories de travailleurs pouvant être considérés comme complémentaires aux machines automatisées, plutôt que concurrents. En sus, les politiques publiques pourront s'efforcer d'assurer un partage général des bénéfices économiques engendrés.

1.2 The National Artificial Intelligence Research & Development Strategic Plan (NSTC, octobre 2016)

Ce plan stratégique, publié en octobre 2016, présente une série d'objectifs à poursuivre pour la recherche en IA financée par des fonds publics fédéraux, avec l'ambition de couvrir à la fois les efforts de recherche directement produits par des entités fédérales et ceux des organisations externes, au premier rang desquelles les universités, tout en essayant de mettre l'accent sur les domaines dans lesquelles l'industrie est moins susceptible d'intervenir. Sept priorités en constituent le coeur stratégique :

• Investissement fédéral soutenu dans la recherche à long terme afin de produire des percées scientifiques et technologiques dans les dix prochaines années, en particulier dans les nouvelles méthodologies nécessaires à la découverte de savoir à l'heure des grands volumes de données, l'amélioration des capacités de perception des systèmes d'intelligence artificielle, la compréhension profonde des capacités théoriques et des limites propres au développement de l'intelligence artificielle, la poursuite des efforts visant au développement d'une IA générique par opposition aux intelligences artificielles spécifiques, la nécessité de développer des systèmes d'intelligence artificielle extensible, l'accélération de la recherche sur une intelligence artificielle s'approchant des capacités humaines.

• Développement de méthodes de collaboration entre homme et intelligence artificielle : systèmes fonctionnant en parallèle, en substitution au moment où l'individu atteint ses limites cognitives ou en substitution totale.

• Compréhension accrue des implications légales, sociétales et éthiques, en particulier développement de méthodes permettant de concevoir des systèmes d'intelligence artificielle conformes aux principes éthiques, légaux et sociétaux des États-Unis. Plus précisément, le rapport insiste sur l'importance d'assurer la justice, la transparence et la responsabilité des systèmes, dès la phase de conception.

• Sécurité et sûreté des systèmes, en particulier dans l'adaptation à des environnements complexes et/ou incertains.

• Développement de bases de données publiques partagées et d'environnements pour l'entraînement et le test de systèmes d'intelligence artificielle, à commencer par la mise à disposition de jeux de données fédéraux existants.

• Développement d'un spectre large de standards visant à assurer que les technologies émergentes répondent à des objectifs précis en termes de fonctionnalité et d'interopérabilité, ainsi qu'en termes de sécurité et de performance.

• Évaluation des besoins nationaux en termes de main-d'oeuvre.

1.3 Artificial Intelligence, Automation and the Economy ( Executive Office of the President , décembre 2016)

Dans la foulée des deux précédents, l' Executive Office of the President vient de produire un troisième rapport, cosigné par plusieurs branches, et centré sur les implications économiques, en particulier sur le marché du travail, du développement de l'intelligence artificielle.

S'il en souligne comme toujours les bénéfices économiques attendus, il soulève la question de la répartition de ces bénéfices, en évoquant en particulier le risque que cette répartition asymétrique contribue de manière décisive à creuser les inégalités entre les travailleurs hautement qualifiés et les autres. Bien qu'il soit hasardeux d'essayer de prédire exactement quels emplois seront le plus tôt impactés par l'automatisation conduite par l'intelligence artificielle (aussi bien en termes de destruction d'emplois que de création de nouveaux emplois, par exemple de supervision de l'intelligence artificielle), le rapport pointe que, d'après les experts, l'ampleur des volumes d'emplois directement menacés dans les décennies à venir serait comprise entre 9 % et 47 % du volume total d'emplois, le plus largement concentrés au sein des groupes de travailleurs les moins diplômés et les moins bien rémunérés, ce qui implique qu'un des effets directs de cette vague d'automatisation pour ce groupe résidera dans la pression vers le bas des salaires. Le rapport va même jusqu'à pointer très explicitement la menace selon laquelle l'automatisation en question pourrait bien ne bénéficier qu'à quelques-uns, de par la nature hautement hégémonique (« winner-takes-most » ) des marchés liés aux technologies de l'information.

Cela étant, le rapport insiste par contraste sur la capacité des politiques publiques et des incitations institutionnelles à réguler les effets du changement technologique (« Technology is not destiny » ). Il formule dès lors un certain nombre de propositions stratégiques dont il estime qu'il est encore plus important qu'elles soient mises en oeuvre au regard du contexte d'émergence massive à moyen terme de l'intelligence artificielle et de l'automatisation :

• Investir dans et développer l'intelligence artificielle en en reconnaissant les bénéfices, à la fois en termes de croissance de la productivité et de volonté de rester à la pointe de l'économie de l'innovation, en menant des politiques volontaristes d'accès à cette économie, en particulier du point de vue de la diversité.

• Éduquer et former les Américains aux emplois du futur, que ce soit de manière précoce, dans la capacité des politiques d'enseignement à rendre accessible financièrement l'enseignement postsecondaire, ou dans l'apprentissage tout au long de la carrière professionnelle.

• Soutenir les travailleurs en transition (en particulier en accroissant la disponibilité des dispositifs de sécurisation de l'emploi et de la transition vers l'emploi, mais également l'accroissement des salaires).

2. Quelques repères sur la recherche en intelligence artificielle aux États-Unis

L'objectif de cette section est de proposer quelques repères sur la recherche en intelligence artificielle aux États-Unis, sans volonté d'exhaustivité dans la présentation de ce paysage scientifique.

2.1 Quelques grands centres

L'excellence de certaines universités comme le MIT, Stanford et Harvard n'est plus à démontrer et celles-ci abritent des équipes et des chercheurs qui jouent un rôle important dans la recherche en IA.

MIT : Computer Science and Artificial Intelligence Laboratory (CSAIL)

Le Massachusetts Institute of Technology (MIT) possède avec le CSAIL un centre dédié à l'IA qui est remarquable de par la forte diversité dans les thématiques traitées, le nombre et la qualité de ses équipes de recherche. L'ensemble des cinquante équipes regroupe mille deux cents personnes dont environ trois cents chercheurs, huit cents étudiants (six cents graduate students , deux-cents undergraduate students ). Par rapport à la démographie usuelle en France, il est intéressant de noter la proportion beaucoup plus forte d'étudiants (pour ces thématiques, la répartition usuelle en France est plutôt de 50 % de chercheurs et 50 % d'étudiants).

Carnegie Mellon University (CMU)

Carnegie Mellon University (CMU) est une université moins connue mais pourtant essentielle dans le paysage de l'informatique avec ses douze récipiendaires du prix Turing (par comparaison, la France n'en compte qu'un seul), qui est l'équivalent du prix Nobel pour l'informatique. Avec son institut de Robotique, qui a été le premier créé aux États-Unis en 1970, CMU a joué et joue toujours un rôle central dans ce domaine. Cet institut abrite notamment le Field Robotic Center qui conçoit des robots capables de travailler dans des conditions extrêmes (explorations polaires et explorations spatiales par exemple) et le NanoRobotics lab dont l'objet d'étude est centré sur les nanorobots avec notamment des applications en médecine très prometteuses.

Stanford Artificial Intelligence Laboratory (SAIL)

Pour illustrer la forte interaction entre le monde académique et le monde industriel, on peut noter qu'en liaison avec le SAIL, l'Université de Stanford a créé un laboratoire conjoint avec Toyota, le Stanford-Toyota Research Center , dont l'objet d'étude n'est pas exclusivement le véhicule autonome mais, de manière plus large, le développement des interactions entre l'homme et les machines intelligentes. Ce laboratoire pluridisciplinaire regroupe vingt et un chefs de projets qui travaillent sur douze thématiques liées à l'intelligence artificielle 2 ( * ) .

Berkeley Artificial Intelligence Research (BAIR)

Beaucoup plus petit que le CSAIL du MIT (vingt-cinq professeurs pour une centaine d'étudiants diplômés), ce laboratoire couvre les principaux domaines de l'IA (vision par ordinateur, apprentissage automatique, traitement automatique des langues et robotique). Ce laboratoire se caractérise par l'excellence scientifique de certains de ces membres dont quelques professeurs emblématiques comme Michael I. Jordan et Stuart Russell, mais aussi le très prometteur Sergey Levine qui applique avec succès des techniques d'apprentissage automatique en robotique 3 ( * ) . On notera que l'Université de Californie à Berkeley vient de lancer un Centre de Recherche dédié aux interactions entre l'homme et l'intelligence artificielle ( Centre for Human-Compatible Artificial Intelligence - CHCAI) piloté par Stuart Russell.

2.2 Quelques acteurs importants aux États-Unis

Les États-Unis ont une capacité d'attractivité exceptionnelle et ont réussi à attirer plusieurs grands scientifiques de la discipline.

2.2.1 Les pionniers

Alan Turing (1912-1954) : d'origine britannique, il est considéré comme le père fondateur de l'informatique avec ses contributions fondamentales sur la décidabilité. Il est resté célèbre dans le monde de l'intelligence artificielle par sa proposition du test de Turing qui vise à déterminer si une machine est dotée d'intelligence artificielle. Ce test qui consiste à tester la capacité de confondre un ordinateur avec un interlocuteur humain est aujourd'hui remis en cause pour prendre en compte la grande variété des critères et caractéristiques d'un être ou d'une machine intelligente.

John McCarthy (1927-2011) et Marvin Lee Minsky (1927-2016) : John McCarthy a été professeur à Stanford et au MIT. Ce mathématicien est à l'origine du terme « intelligence artificielle » et l'inventeur du langage de programmation LISP qui était très populaire du temps des systèmes experts. Ses travaux autour de la logique symbolique sont essentiels en théorie des jeux (il est à l'origine de l'élagage alpha-bêta permettant de réduire l'espace d'exploration dans un arbre de possibilités). Il est avec Marvin Minsky l'un des organisateurs de l'école d'été à Dartmouth où le concept d'IA a émergé. Marvin Minsky est un spécialiste des sciences cognitives, co-fondateur du laboratoire d'intelligence artificielle au MIT. Il fut notamment le créateur du premier calculateur basé sur les réseaux de neurones.

2.2.2 Les contemporains

Les trois prix Turing américains en IA : Edward Feigenbaum (1994) , Leslie Valiant (2010) et Judea Pearl (2011) : Après des études à l'Université Carnegie-Mellon, Edward Feigenbaum est devenu professeur d'informatique et codirecteur scientifique du Knowledge Systems Laboratory à l'Université de Stanford. Il a obtenu le Prix Turing pour ses travaux dans les domaines de l'étude et la construction de systèmes d'intelligence artificielle à grande échelle. Judea Pearl était professeur à New York University (NYU) et a reçu le prix Turing pour ses travaux sur les calculs de probabilités et les approches bayésiennes en Intelligence Artificielle. Leslie Valiant est un britannique, professeur à Harvard, et reconnu notamment pour son modèle PAC en théorie de l'apprentissage.

Les récipiendaires de IJCAI / AAAI (principales conférences du domaine), Michael I. Jordan et Barbara J. Grosz : Michael I. Jordan est professeur à Berkeley et lauréat du prestigieux prix IJCAI en 2016 pour ses travaux en apprentissage automatique. Michael I. Jordan est également membre de l'Académie des sciences et a obtenu la chaire d'excellence de la Fondation des Sciences Mathématiques de Paris en 2012. Barbara J. Grosz est professeur à l'Université d'Harvard et spécialiste du Traitement Automatique des langues et des systèmes multi-agents. Elle a reçu le prix IJCAI en 2015 et le prix de l'ACM/AAAI Allen Newell en 2009.

Une responsable de la société savante , Manuela Veloso : Manuela Veloso est professeur à CMU et préside la principale société savante en IA, l'Association for the Advancement of Artificial Intelligence (AAAI). Cette scientifique qui travaille dans le domaine des multi-agents défend une approche baptisée « Symbiotic Autonomy » qui est basée sur la collaboration entre humains et robots en fonction du contexte.

Des scientifiques impliqués dans les enjeux sociétaux liés à l'IA, de Gary Marcus à Stuart Russell, en passant par Elon Musk : Gary Marcus est professeur de psychologie à New York University et est connu pour ses romans et aussi son leadership dans le mouvement pour remplacer le test de Turing par une série de tests baptisée « Turing Olympics » 4 ( * ) . On ne présente plus Elon Musk : ce Sud-Africain d'origine est devenu créateur d'entreprises innovantes (Tesla Motors, SpaceX) et symbolise parfaitement la puissance d'innovation technologique américaine. Il est le cofondateur et le coprésident d'OpenAI 5 ( * ) qui vise à promouvoir l'open source en intelligence artificielle. La promotion du logiciel libre est particulièrement importante pour la recherche mais aussi pour l'émergence de start-up en particulier en France dans le domaine. Quant à Stuart Russell, professeur à Berkeley, est un scientifique de renom qui explore différentes facettes de l'intelligence dans ses travaux. Il est notamment connu pour ses contributions sur l'apprentissage par renforcement hiérarchique et ses réflexions sur les impacts sociétaux de l'IA, notamment le danger potentiel des armes autonomes. Stuart Russell a été titulaire d'une chaire Blaise Pascal de la Région Île-de-France de 2012 à 2014.

2.3 Quelques tendances dans différents domaines de l'intelligence artificielle

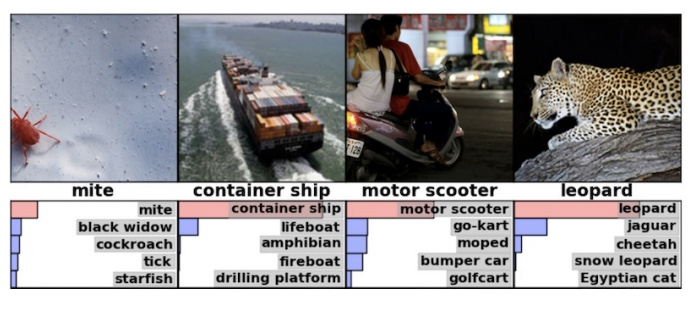

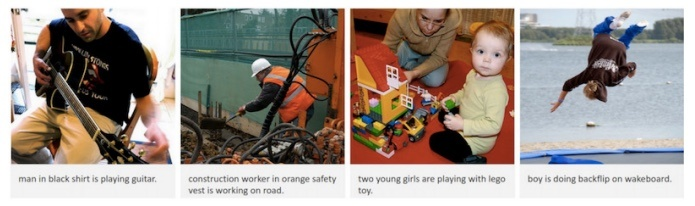

Vision par ordinateur ( Computer Vision ) : La principale tendance dans ce domaine de recherche est caractérisée par le passage de méthodes dites supervisées (nécessitant une intervention humaine) à des méthodes peu supervisées voire non supervisées. L'objectif est de pouvoir indexer des quantités de données de plus en plus grandes. L'indexation consiste à proposer des algorithmes pour extraire des éléments sémantiques caractéristiques liés à la perception telle que la reconnaissance d'objets, la détection de séquences dans des vidéos, la description de contenus (personnes, activités, mouvements, ...). Ce domaine est essentiel pour faire face aux défis scientifiques posés par le big data .

Apprentissage automatique ( Machine Learning ) : Ici encore, comme le souligne Yann LeCun, la principale tendance est le développement de l'apprentissage non supervisé. Une autre tendance forte est la recherche sur la compréhension par des non-experts des conclusions, actions et décisions retournées par les programmes d'IA. La DARPA vient de lancer un programme spécifique sur cette thématique 6 ( * ) . Cela implique des défis scientifiques mais aussi des problèmes pour former les générations futures à ces techniques, pour les démythifier et les comprendre. Un autre défi important pour ce domaine est souligné dans le rapport du département de la défense US 7 ( * ) . Il s'agit, notamment pour les technologies d'apprentissage profond ( deep learning) , de satisfaire aux propriétés souhaitables pour tout logiciel critique : preuve, maintenance, évolutivité, robustesse. Ces aspects posent des problèmes scientifiques complexes et nécessitent des collaborations entre des communautés scientifiques distinctes. L'importance de l'accès aux données et les enjeux économiques pour ces thématiques liées à l'apprentissage automatique fait que le secteur industriel économique et notamment les GAFA (Google, Apple, Facebook, Amazon) américains proposent une recherche de pointe dans ces domaines.

Robotique : la robotique est un secteur qui a également énormément évolué dans la dernière décennie, d'une part, en raison des progrès technologiques notamment sur les capteurs et, d'autre part, en raison des enjeux économiques et sociétaux qui ont suscité de nombreux investissements. Côté US, on peut citer les travaux du MIT sur le robot guépard 8 ( * ) mais aussi le robot humanoïde proposé par Google / Alphabet et Boston Dynamics 9 ( * ) capable de courir dans les bois. Concernant les perspectives, nul doute que les nanorobots seront au coeur de nombreux progrès scientifiques et technologiques dans les prochaines années.

2.4 Les États-Unis, un acteur majeur de la recherche en IA

Les États-Unis sont ainsi, comme d'ailleurs dans la plupart des domaines scientifiques, un acteur majeur de la recherche en intelligence artificielle. Le principal atout du pays est sans doute sa capacité à :

• attirer les meilleurs scientifiques et les talents les plus prometteurs,

• proposer de grands programmes et laboratoires thématiques en liaison avec ses agences (NSF 10 ( * ) , NASA 11 ( * ) , DARPA 12 ( * ) , NIH, ...) et

• promouvoir l'innovation à travers un écosystème très efficace impliquant le monde académique et le monde industriel.

Il est également important de souligner la perméabilité des domaines scientifiques qui fait que l'innovation scientifique et technologique se retrouve souvent à la convergence de plusieurs domaines. L'IA a ainsi bénéficié des progrès récents dans le domaine du big data et du calcul haute performance (HPC).

Nul doute que la convergence des mondes numérique et physique avec le développement de l'Internet des objets et des véhicules autonomes sera la source de nombreux progrès où l'intelligence artificielle jouera un rôle majeur.

D'autres domaines comme la cybersécurité sont au coeur de la politique scientifique dans le numérique aux États-Unis avec des connexions fortes dans le monde de l'intelligence artificielle pour détecter et contrer les attaques.

Dans tous ces domaines les collaborations scientifiques entre la France et les États-Unis sont une réalité. Inria possède par exemple quarante équipes associées entre des équipes françaises et américaines. Le CNRS possède un Groupe de recherche international (GDRI) impliquant les États-Unis dans le domaine de l'intelligence artificielle et un laboratoire commun (UMI) avec Georgia Tech.

3. La course industrielle à l'armement

Naturellement, les promesses de croissance économique ouvertes par cette nouvelle rupture technologique ne pouvaient laisser indifférent l'écosystème des grands acteurs privés de l'innovation aux États-Unis.

3.1 Les reconfigurations internes des géants industriels

Il est notable que 2016 aura été l'année durant laquelle les géants industriels technologiques, notamment de la côte ouest, ont opéré une série de réorganisations internes destinées à mettre en avant des services de cloud computing spécialement conçus pour les avancées en intelligence artificielle.

C'est ainsi que par exemple Google/Alphabet vient de recruter Fei-Fei Li, directrice des Artificial Intelligence and Vision Labs de Stanford pour diriger son groupe d'apprentissage automatique dans le cloud , lequel inclura rapidement des services en reconnaissance d'image, reconnaissance vocale, traduction automatique ou compréhension du langage naturel. Microsoft, Amazon ou IBM ont tous engagé des restructurations similaires.

Une des raisons pour focaliser ce type d'effort réside dans la prédiction selon laquelle, le cloud étant promis à constituer une part dominante de la génération de leur chiffre d'affaires, l'infusion de cette partie de leur activité par les technologies d'intelligence artificielle et d'apprentissage automatique constitue un avantage comparatif décisif.

Plus encore, il s'agit pour ces sociétés de faire percoler ces technologies dans l'ensemble des divisions et produits associés des susdites sociétés. Microsoft vient par exemple de créer une division entière au sein de laquelle son vice-président exécutif pour la recherche et la technologie, Harry Shum, conduit plus de cinq mille ingénieurs et informaticiens à travailler à la diffusion des technologies d'intelligence artificielle dans l'ensemble des produits de la société (le moteur de recherche Bing, l'assistant personnel Cortana ou les activités robotiques de la société en constituent les exemples les plus notables). Comme souvent, Google/Alphabet avait été un précurseur en la matière avec sa division Google Brain (portée par Andrew Ng, désormais à Baidu) qui travaille avec l'ensemble des autres divisions de Google/Alphabet. De la même manière, un ingénieur de Facebook sur cinq travaille désormais à partir des résultats en apprentissage automatique du pourtant récent Applied Machine Learning Group .

Il n'est d'ailleurs pas inintéressant de noter que la rareté relative des talents en intelligence artificielle (à l'inverse de ceux en programmation classique) conduit les grands industriels technologiques de la Silicon Valley à injecter des ressources significatives dans la formation (et la rétention) de ses employés : Google/Alphabet a monté un programme de formation interne en apprentissage automatique, et Facebook offre des formations similaires tout en construisant des parcours internes de transfert vers des missions à plein temps de recherche dans le domaine exclusif de l'intelligence artificielle.

3.2 Les stratégies d'acquisition

Une autre voie d'immersion pour les entreprises industrielles réside naturellement dans le déploiement d'une stratégie d'acquisition de sociétés plus petites, d'autant qu'elle s'accompagne souvent d'une volonté de rétention des personnels clés de ces dernières (ce qui se désigne par le terme d' acqui-hire ).

Les chiffres parlent d'eux-mêmes : on passe d'un volume global d'acquisition de start-up spécialisées en intelligence artificielle de sept en 2012 pour tout le territoire américain, à trente-trois en 2014, puis trente-sept en 2015 et quarante-deux simplement pour les trois premiers trimestres de 2016.

Là encore, Google/Alphabet est à la fois un précurseur en la matière, puisqu'il a acquis dès 2013 la start-up d'apprentissage automatique issue de l'Université de Toronto DNNresearch, puis surtout en 2014 pour 600 M$ la société britannique DeepMind Technologies, connue pour avoir enfanté un programme capable de battre le meilleur joueur mondial de go, et celui qui pratique cette stratégie avec le plus d'intensité et de constance (onze acquisitions au total, dont les plus récentes sont la start-up de recherche visuelle Moodstock et la plateforme de langage naturel Api.ai).

Mais ses concurrents directs ne sont pas en reste : Intel a acquis cinq start-up (dont trois en 2016), de même qu'Apple (deux en 2016), Twitter quatre (dont la très prometteuse start-up britannique de traitement d'image Magic Pony pour 150M$) et Salesforce, qui a démarré son effort en 2016, trois.

De manière intéressante, on voit désormais apparaître dans la course des entreprises industrielles non initialement liées dans leur coeur technologique à l'informatique et à l'Internet, le meilleur exemple en étant General Electric (deux acquisitions en novembre 2016)

3.3 A l'autre bout du spectre, l'expansion de l'écosystème de start-up en intelligence artificielle

Dans un marché de l'investissement en capital-risque sinon atone, du moins plafonnant après les records de l'année précédente, les start-up liées à l'intelligence artificielle et à l'apprentissage automatique connaissent a contrario une envolée spectaculaire de leur attractivité financière. Le troisième trimestre 2016 est à cet égard archétypal : une croissance impressionnante tant en volume global (705 M$) qu'en nombre d'accords (71), soit une hausse respective de 16 % et 22 % par rapport au trimestre précédent, avec une tendance qui continue à accélérer.

L'élément le plus frappant réside cependant sans doute dans le degré inégalé de transversalité sur des verticales sectorielles par les start-up liées à l'intelligence artificielle, lesquelles attaquent désormais tous les marchés : le langage, la vision, l'automobile, la cybersécurité, la robotique, le marketing, l'intelligence économique, la génération de texte, l'Internet des objets, le commerce, les technologies financières, l'assurance, l'agriculture ou l'imagerie satellitaire. Mais la diversité de champs applicatifs au sein de ces marchés est tout aussi spectaculaire : si on considère le secteur qui a généré ces deux dernières années le plus d'investissement en capital-risque pour des start-up en intelligence artificielle, celui de la santé, on trouve aussi bien des sociétés qui travaillent sur la gestion du risque que sur la recherche génétique, la nutrition, l'imagerie médicale, le diagnostic, le monitoring individuel, la gestion des urgences hospitalières, la découverte de médicaments, l'oncologie ou la santé mentale. L'intelligence artificielle est donc bien devenue un marché total.

2. En Chine

Note réalisée avec le concours du service scientifique de l'Ambassade de France en Chine

L' intelligence artificielle (IA) est une discipline scientifique recherchant des méthodes de résolution de problèmes à forte complexité logique ou algorithmique. Par extension elle désigne, dans le langage courant, les dispositifs imitant ou remplaçant l'humain dans certaines mises en oeuvre de ses fonctions cognitives.

Historiquement, elle trouve son point de départ avec les travaux de Turing dans les années 1950 et a suivi l'évolution de l'informatique. Le développement des technologies informatiques et en particulier l'explosion récente des puissances de calculs et de la capacité de capter et manipuler des quantités importantes de données ont permis, à l'aide d'algorithmes théorisés dans les années 1970, la réalisation de programmes informatiques surpassant l'homme dans certaines de ses capacités cognitives emblématiques.

Le sujet se trouve à l'interface de nombreuses disciplines. L'informatique est au centre mais en lien avec les modèles mathématiques sous-jacents - réseaux et statistiques pour l'analyse de données massives -, la biologie et en particulier les neurosciences, au moins comme source d'inspiration pour affiner les architectures, les sciences sociales comme les sciences cognitives ou la linguistique, mais aussi souvent les sciences liées aux applications concernées, de la ville intelligente à la médecine en passant par l'éducation ou l'automobile.

La Chine se trouve au coeur de l'évolution récente de ces techniques et déploie d'importants moyens pour devenir leader dans le domaine.

Parmi ses atouts, mentionnons l'importance de la part du PIB consacrée à la recherche et la mise en avant de la recherche autour de l'IA ; sa position dominante dans le classement du TOP 500 (deux supercalculateurs en tête de cette liste) ; la collusion État/géants du net et de l'informatique/instituts de recherche/universités/start-up ; un marché très important et friand des avancées potentielles du secteur ; une opinion publique peu préoccupée par les questions philosophiques soulevées ni par les questions concernant la protection des données qui sont des enjeux importants pour l'évolution et les applications de l'IA.

Ces avantages et les succès chinois annoncés en la matière sont à nuancer par certains handicaps : politique de communication parfois un peu arrogante et certaines fois déconnectée de la réalité (que ce soit pour la hauteur effective des financements ou la qualité des résultats obtenus) ; choix parfois guidés par une volonté plus de coller aux « indicateurs » que de faire progresser la science ; la plupart des progrès visibles reposent encore sur des architectures conçues par des scientifiques occidentaux ; existence de multiples réseaux parfois concurrents se livrant à une compétition pas toujours très constructive (cela oblige d'ailleurs pour se faire une idée à identifier les différents réseaux) ; la pluridisciplinarité qui semble requise pour des avancées sérieuses en IA n'est pas dans la tradition scientifique chinoise ; et puis, mais ce n'est pas propre à la Chine, il y a une nette tendance à qualifier d'IA tout algorithme un peu original et pas trop bête.

Généralités

Le 13 e plan quinquennal comprend une liste de quinze « nouveaux grands projets - innovation 2030 » qui structurent les priorités scientifiques du pays et correspondent chacun à des investissements de plusieurs milliards d'euros. Parmi ces quinze projets, on trouve un projet de « Recherche sur le cerveau » et des projets d'ingénierie intitulés « Mega données », « Réseaux intelligents » et « Fabrication intelligente et robotique ». Si le terme « intelligence artificielle » n'apparaît pas explicitement, il est clairement sous-jacent dans ces quatre projets, ce qui signifie qu'un effort considérable va être développé dans cette direction.

À la manière locale, certains chercheurs présentent pour la communauté scientifique chinoise une feuille de route ambitieuse :

1. Actuellement, développement de machines ayant une intelligence par domaine (" Artificial Narrow Intelligence " - ANI) (reconnaissance d'objets, compréhension du langage naturel, assistant personnel...). Ces techniques pouvant être appliquées dans un grand nombre de domaines, l'objectif est que la Chine soit leader mondial (en 2020 ?).

2. Vers 2025-2030, développement de systèmes ayant une intelligence générale, comparable à celle du cerveau humain (« Artificial General Intelligence » - AGI). Ici aussi, l'ambition de la Chine est d'être la première à disposer d'un tel système.

3. Puis le développement d'intelligences suprahumaines. C'est d'après ces chercheurs la seule solution pour résoudre les problèmes de la planète - les intelligences humaines, trop limitées, ne peuvent appréhender ce type de problème dans leur ensemble, et donc sont incapables de proposer des solutions efficaces.

Les recherches envisagées ne sont pas seulement théoriques, les applications multiples sont un moteur important : détection des émotions, interface homme-machine, analyse d'images, contrôle de drones, de robots ou d'avatars, interface en langage naturel, automobiles autonomes, etc. Les systèmes permettront aussi de faire l'analyse des big data . L'exemple suivant ne semble pas gêner les collègues qui l'évoquent : « Piloté par le gouvernement et l'organisme central de planification, le dispositif de notation de la population devrait récupérer automatiquement les informations sur les citoyens d'ici à 2020. Il scrutera les activités en ligne, etc, pour générer un score individuel. Il semble que si un seuil est dépassé, l'individu concerné se verra privé d'un certain nombre de droits et de services ».

Une expérimentation a lieu à Suining 13 ( * ) . D'autres dispositifs d'évaluation sont étudiés, comme le Sesame Credit du distributeur en ligne Alibaba (http://www.bbc.com/news/world-asia-china-34592186).

Les réseaux du Service pour la Science et la technologie de ce Poste diplomatique ont pu identifier quelques unités saillantes dans le paysage mouvant travaillant autour de ce sujet, en se reposant essentiellement sur les retours de quatre missions (une mission Découverte Chine sur l'informatique neuro-mimétique, une mission d'experts sur l'IoT, une mission d'experts sur le calcul haute performance et une mission d'experts sur le big data ).

Cerveau

Ainsi la recherche en intelligence artificielle est en partie portée par le projet « cerveau » (qui comporte bien sûr par ailleurs une importante composante plus strictement étiquetée « sciences de la vie »), à travers le pôle « brain-like/ brain-inspired computing » qui est en train de se constituer. Il implique en particulier trois acteurs majeurs de la recherche : la Chinese Academy of Sciences (CAS), l'Université Tsinghua et l'Université de Pékin (Beida) qui pour l'instant ont développé leurs propres réseaux. Le programme « CASIA brain » est une collaboration entre six instituts de l'Académie des sciences chinoise qui implique, entre autres, l'institut d'automatique (CASIA) et l'institut de technologie informatique (ICT-CAS). De son côté, l'Université Tsinghua pilote le Center for Brain-Inspired Computing Research (CBICR) qui relie des partenaires dans toute la Chine et se présente comme résolument « transdisciplinaire » au moins au sein de l'informatique. Le groupe de l'Université de Pékin semble moins structuré nationalement mais entretient d'importantes coopérations avec les pays anglo-saxons. Dans tous ces cas, l'idée directrice est de travailler simultanément sur des aspects hardware et logiciel pour concevoir des circuits susceptibles de fonctionner « comme le cerveau » pour apprendre à résoudre les problèmes posés.

Dans la veine de l'informatique neuro-mimétique, on relève aussi des travaux intéressants à Hangzhou (Projet Darwin, College of Computer Science, Université de Zhejiang) et à Shanghai ( Center for Brain Like Computing and Machine Intelligence de l'Université Shanghai Jiaotong).

Big data

Parfois au sein des mêmes institutions, les laboratoires d'informatique (leur département « logiciel »), parfois au sein de pôles constitués autour des enjeux dits « big data » ou « IoT » développent des outils et intègrent des méthodes avec des objectifs de même nature - du moins pour les objectifs à court terme.

Outre les laboratoires des grandes institutions pékinoises ( CAS Key Lab of Network Data Science and Technology ou Institute for Data Science Tsinghua), on relève le laboratoire Pattern Recognition & Intelligent System Lab . et le laboratoire du logiciel de télécommunication intelligent et multimédia de la Beijing University of Post and Telecomunications (BUPT), la School of Computer Software à Tianjin, le National Key Laboratory for Novel Software Technology de l'Université de Nankin, le Shenzhen Institute of Advanced Technology de la CAS, ou encore le Shanghai Advanced Research Institute de la CAS (centré sur l'IoT), l' Institute of Media Computing de l'Université Fudan, également à Shanghai.

Géants privés

Les enjeux sont nationaux et les financements suivent. Mais les entreprises privées sont aussi des moteurs puissants du secteur.

En tête, l'entreprise Baidu (qui a développé le moteur de recherche chinois, site le plus consulté en Chine et cinquième au niveau mondial, indexant près d'un milliard de pages, cent millions d'images et dix millions de fichiers multimédia) communique beaucoup sur le sujet, consacre une part conséquente de sa recherche au sujet ( Insitute of deep learning , Big data lab ,...) et, comme les géants américains, dispose d'un flux de données permettant d'envisager des applications dans de nombreux domaines.

L'entreprise considère, comme ses concurrents, que l'IA est son prochain challenge comme solution clé pour des applications en vision, parole, traitement du langage naturel et sa compréhension, génération de prédictions et de recommandations, publicité ciblée, planification et prise de décision en robotique, conduite autonome, pilotage de drones,... Elle travaille en étroite relation avec de nombreuses universités et start-up.

Les résultats algorithmiques de l' Institute of Deep Learn ing de Baidu sont impressionnants et du meilleur niveau mondial, malgré son existence récente. Mentionnons pour donner une idée, la capacité de leurs algorithmes à retrouver une image dans une base de données de 10 milliards d'images en moins d'une seconde. Ils ont aussi de bonnes performances sur les benchmarks ICDAR (1 er sur 5/8 évaluations parmi 4 tâches).

Sur FDDB ( Face Detection Data Set and Benchmark , voir http://vis-www.cs.umass.edu/fddb/ ) et sur la base de données de visages LFW, ils progressent vite (8 % d'erreurs en décembre 2015, 2,3 % en septembre 2016 et bientôt 1 %). L'entreprise annonce aussi la meilleure précision sur la collection de benchmarks KITTI ( http://www.cvlibs.net/datasets/kitti/ ) orientés pour la conduite de voitures autonomes. Baidu développe aussi des applications de reconnaissance d'image pour la plateforme de services Baidu Nuomi : une application permet par exemple de reconnaître le restaurant (et le plat) en prenant une photo de nourriture dans un restaurant.

Il n'est pas évident d'évaluer la maîtrise théorique des ingénieurs mais l'entreprise montre une incontestable efficacité pour implémenter rapidement les dernières innovations du secteur.

Les autres géants chinois du net, comme Alibaba (distribution) ou Tencent (réseaux sociaux), tirent eux aussi dans la même direction : développement et diffusion grand public d'applications plus ou moins convaincantes mais manifestement exploitant des techniques d'IA un peu évoluées, même s'ils semblent moins présents dans la recherche « fondamentale ». Huawei (telecom, téléphones), entreprise qui accorde une grande importance à la recherche fondamentale et dont la recherche s'internationalise rapidement (pôle mathématique implanté en France il y a deux ans) a mis en avant début janvier 2017 un concept de téléphone intelligent, dont on ne peut encore savoir s'il ira effectivement plus loin que ceux de ses concurrents.

Plus globalement concernant les données, les pôles universitaires peuvent aussi compter sur le support des industriels comme, par exemple, National Grid, China Mobile, China Unicom, China Mobile, Shanghai Meteorological Bureau ou Environmental Monitoring Center.

Innovation et start-up

Le paysage chinois de l'innovation - incitation à très grande échelle pour soutenir l'innovation privée, en particulier par la multiplication de petites structures - conjugué à l'effet de mode « attractif » du secteur IA fait éclore dans tout le pays et en particulier aux abords des (voire dans les) universités, des entreprises cherchant à exploiter ce filon, souvent en proposant des services originaux ; sous l'oeil (attentif et bienveillant) de l'État et des géants. Ces initiatives ne sont pas toutes scientifiques. Il s'agit souvent d'abord de marketing, mais pas toujours ou pas seulement.

On peut mentionner par exemple la société Cambricon, très proche de l'ICT de la CAS : le professeur Chen Yunji continue de développer des accélérateurs neuronaux (à l'ICT de la CAS) de la famille DianNao à partir de travaux réalisés en coopération avec des chercheurs du CEA (Marc Duranton) et d'Inria (Olivier Temam) ; son frère Chen Yianshi est maintenant le P-DG d'une start-up « Cambricon Technologies Corporation Limited » fondée en mars 2016, comptant 100 employés en septembre 2016 et ayant un objectif de 200 pour fin 2016, qui travaille sur des accélérateurs neuronaux inspirés fortement de la famille DianNao. Le projet de la société est d'utiliser ces accélérateurs pour permettre le traitement intelligent des images et des signaux embarqués (au lieu d'architectures GPU / DSP actuelles) améliorant les performances énergétiques d'un facteur 4000. Le chercheur Marc Duranton qui a eu accès (limité) à la société estime que cette perspective est prometteuse.

Sur le marché des robots de service, intégrant de l'IA en particulier pour la partie reconnaissance vocale, mentionnons par exemple Yunji Technology (robots déployés dans des hôtels à Pékin et Shanghai), iFLYTEK (moteur de reconnaissance vocale) ou Ninebot Inc (Transport intelligent).

Certaines sociétés françaises du secteur, comme par exemple Air Visual (suivi et prédiction de la pollution de l'air) ou WosomTech (reconstruction 3D prédictive ; approchée par Lenovo récemment) ont une expérience en Chine et connaissent un peu le paysage de l'intérieur.

Personnes ressources à privilégier

Mentionnons tout d'abord les trois principaux acteurs de ce qui devrait constituer le pôle « brain-like/inspired computing » du projet de recherche sur le cerveau Il s'agit de HUANG Tiejun, SHI Luping et XU Bo, travaillant respectivement à l'Université de Pékin, à l'Université Tsinghua et à l'Institut d'Automatique de la CAS.

Le NLPR ( National Laboratory of Pattern Recognition ) dirigé par TAO Jinhua est l'un des laboratoires de l'Institut d'Automatique de la CAS. Il est notable qu'il héberge le principal laboratoire franco-chinois du domaine, le LIAMA (Laboratoire d'Informatique, d'Automatique et de Mathématiques Appliquées) du domaine. L'intelligence artificielle, et en particulier ce qui tourne autour du « brain-inspired computing » est l'un des sujets mis en exergue lors de la dernière rencontre organisée par le LIAMA (Pékin, Octobre 2016).

Le Professeur TAO Jinhua a encadré au NPLR la thèse d'un étudiant qui a obtenu récemment un « one-million prize » décerné par l'entreprise Baidu - pour son travail sur la reconnaissance vocale et la production de parole. L'une de ses étudiantes actuelles travaille sur la reconnaissance des émotions dans la voix humaine. C'est nous semble-t-il un contact précieux dans ce secteur.

ZHOU Zhihua est directeur adjoint de l'équipe LAMDA (Learning And Mining from DAta), affiliée au National Key Laboratory for Novel Software Technology et au Department of Computer Science & Technology. C'est un chercheur qui a aujourd'hui une véritable envergure internationale et qui est une valeur montante de l'apprentissage statistique en Chine.

Les Hub French Tech récemment labellisés à Pékin, Shanghai et Shenzhen peuvent constituer d'excellents points d'entrée pour accéder aux start-up françaises du secteur ayant des intérêts en Chine.

QIU Xipeng : vice dean du Big Data School de l'Université de Fudan.

3. Au Japon

Note réalisée avec le concours du service scientifique de l'Ambassade de France au Japon

L'intelligence artificielle est considérée comme l'élément clé de la révolution numérique au Japon. Le gouvernement japonais en a fait le socle de sa nouvelle stratégie en science, technologie et innovation, qui vise à mettre en place une « société 5.0 », société superintelligente et fer de lance à l'échelle mondiale. Il a annoncé une vague d'investissements massifs dans le domaine, avec 27 milliards de yens pour la seule année 2016, à travers la création de centres de recherche et technologies dédiés à ce domaine. Les partenariats publics-privés entre ces nouveaux centres et les grands groupes japonais se multiplient, afin d'exploiter le potentiel de création de valeur que constitue l'intelligence artificielle sur des applications ciblées.

1. L'intelligence artificielle, au coeur de la stratégie japonaise

1.1. L'intelligence artificielle (AI) dans le « 5e Plan-cadre de la science et de la technologie » et dans le « Livre blanc 2016 sur la science et la technologie »

Les plans-cadres pour la science et de la technologie, élaborés tous les cinq ans depuis 1996 par le Conseil pour la Science, Technologie et Innovation (CSTI, dépendant directement du Cabinet Office, i.e. Les services du Premier Ministre japonais), définissent les priorités de l'État dans les domaines de la science, de la technologie et de l'innovation.

Entré en vigueur le 1 er avril 2016 (le début de l'année fiscale 2016), le 5 e Plan-cadre 14 ( * ) repose sur un nouveau concept de « Société 5.0 », société ultra-intelligente, qui tirerait le meilleur bénéfice des opportunités offertes par les technologies numériques afin de redynamiser le secteur industriel, mais également dans l'optique de réformer la structure même de la société et assurer une prospérité inclusive, dans laquelle les citoyens bénéficieraient de services de haute qualité et adaptés à leurs besoins selon leur âge, sexe, région ou langue. Pour mettre en oeuvre cette société fer-de-lance à l'échelle mondiale, le Japon compte tirer profit de l'expansion très rapide des technologies de l'information et de la communication, parfois considérée comme la « 4 e révolution industrielle », et s'appuyer sur trois piliers : l'Internet des objets (IoT), le big data et l''intelligence artificielle (IA).

L'intelligence artificielle ouvre la voie à des développements très attendus dans le domaine des transports, de la communication, de la traduction automatique ou de la robotique, notamment à l'horizon des Jeux Olympiques et paralympiques de 2020, que le Japon envisage comme une vitrine technologique pour se présenter comme le pays leader en termes d'innovation.

Après la publication du 5 e Plan-cadre pour la Science et la Technologie par le CSTI, le Ministère japonais de l'Éducation, de la Culture, des Sports, des Sciences et de la Technologie (MEXT) a rédigé son livre blanc 2016 pour la science et la technologie, intitulé « Vers la société ultra-intelligente mise en oeuvre par l'IoT, le big data et l'IA- pour que le Japon soit un précurseur mondial », adopté en Conseil des ministres le 20 mai 2016. Ce rapport signale l'insuffisance au Japon de la formation et de la recherche fondamentale en informatique, qui devraient venir soutenir le développement des technologies de l'information et de la communication.

Enfin, à l'occasion de l'organisation du G7 au Japon, le Japon a pris l'initiative d'organiser une réunion ministérielle G7 consacrée aux Sciences et technologies de l'information et de la communication (format qui n'avait pas été mis en oeuvre depuis 20 ans). Pour faire suite à la tenue de cet événement en avril à Takamatsu, les ministres en charge des Sciences et Technologies de l'Information (ICT) se sont accordés dans leur déclaration conjointe à promouvoir la R&D pour les technologies ICT, notamment dans le domaine de l'intelligence artificielle. Ils ont mis l'accent sur l'importance de mettre en place des politiques adaptées, permettant de prendre en compte l'impact sociétal et économique colossal de ces technologies.

1.2. Mise en place de deux comités pour le suivi de ces stratégies

Création d'un Comité de délibération sur l'IA et la société humaine

Le 12 avril 2016, à l'issue de la réunion régulière du Conseil des ministres, Mme Aiko Shimajiri, Ministre chargée de la politique de la science et de la technologie, a annoncé la mise en place d'un « Comité de délibération sur l'AI et la société humaine » au sein du Cabinet Office. Il s'agit de la première entité gouvernementale ayant pour mission d'étudier les enjeux liés à l'IA selon cinq points de vue, à savoir : l'aspect éthique, l'aspect légal, l'aspect économique, l'aspect social et l'aspect R&D. Ce Comité, présidé par Mme Yuko Harayama, membre exécutif permanent du CSTI du Cabinet Office, est composé de 11 experts. La première réunion s'est tenue le 30 mai 2016 en présence de la ministre Shimajiri. Le Comité s'est réuni sur une base mensuelle jusqu'en septembre 2016 pour analyser les activités nationales et internationales et approfondir la problématique. Il a choisi de se baser sur des cas d'application précis, mettant en oeuvre des technologies qui devraient voir le jour à court terme : le véhicule autonome, l'automatisation de l'appareil de production et la communication homme/machine. Il souhaite également engager un débat avec le grand public (par le biais essentiellement de séminaires ouverts et de questionnaires en ligne).

Le Comité devra remettre avant la fin de l'année 2016 ses conclusions, qui seront prises en compte dans la nouvelle Stratégie globale pour la Science, Technologie et Innovation qui sera publiée en juin 2017. Les discussions au niveau international en la matière sont prévues à partir de 2017. Mme Harayama a présenté à Paris le 17 novembre 2017, dans le cadre du Technology Foresight Forum 2016 de l'OCDE 15 ( * ) dédié à l'intelligence artificielle, les premières réflexions du comité :

- Éthique : le citoyen peut-il accepter d'être manipulé pour modifier ses sentiments, convictions ou comportements, et d'être catégorisé/évalué, sans en être informé ? Quel impact aura le développement de l'IA sur notre sens de l'éthique et les relations entre les hommes et les machines ? Dans la mesure où elle étend notre temps, notre espace et nos sens, l'IA viendra-t-elle affecter notre conception de l'humanité, notamment notre conception des facultés et des émotions humaines ? Comment évaluer les actions et la création à partir de l'IA ?

- Légal : comment trouver le juste équilibre entre les bénéfices du traitement des big data par l'IA et la protection des informations personnelles ? Est-ce que les cadres légaux existants pourront s'appliquer aux nouvelles problématiques soulevées par l'IA ? Comment clarifier la responsabilité dans le cas d'incidents impliquant de l'intelligence artificielle (par exemple pour le véhicule autonome) ? Quels sont les risques d'utiliser l'IA ? De ne pas utiliser l'IA ?

- Économique : comment l'IA va-t-elle changer notre manière de travailler ? Quelle politique nationale mettre en place pour favoriser l'utilisation de l'IA ? Comment l'IA va-t-elle modifier le monde de l'emploi ?

- Sociétal : comment réduire les divisions liées à l'IA et répartir de manière équitable le coût social de l'IA ? Y-a-t-il une pathologie ou des conflits de société que peut potentiellement engendrer l'IA ? Peut-on assurer la liberté d'utiliser ou non l'IA et assurer le droit à l'oubli ?

- Éducation : quelle politique nationale mettre en place pour faire face aux inégalités que ne manqueront pas de causer l'utilisation l'IA dans le domaine de l'éducation ? Comment développer notre capacité à exploiter l'IA ?

- R&D : quelle R&D développer pour l'IA en respect de l'éthique, de la sécurité, de la protection de la vie privée, de la transparence, de la contrôlabilité, de la visibilité, de la responsabilité ? Comment rendre disponible l'information liée à l'IA de manière à ce qu'un utilisateur puisse prendre la décision d'utiliser ou non l'IA ?

Le comité cherche notamment à approfondir trois voies pour définir des politiques adaptées : la coévolution de la société et de la technologie ; la recherche d'un équilibre entre les bénéfices (services personnalisés à coût abordable) et les risques liés à l'IA (discrimination, perte de protection des données à caractère privé, perte d'anonymat) ; la définition des limites de la prise de décision automatisée.

Un Conseil portant la stratégie des technologies liées à l'IA

Par ailleurs, dans le cadre du « Dialogue privé-public pour les investissements du futur », le Premier ministre Abe a présenté son projet de définir d'ici à la fin de l'année la feuille de route présentant les objectifs de la recherche sur l'AI et ses applications industrielles et de mettre en place un « Conseil de la stratégie des technologies liées à l'AI ».